Los 9 desafíos del aprendizaje automático.

El futuro va a ser increíble, no cabe duda, pero actualmente, la inteligencia artificial (IA) se plantea unas cuantas preguntas y la mayoría tienen que ver con la moral y la ética. ¿Con qué nos ha vuelto a sorprender el aprendizaje automático? ¿Puedes engañar a una máquina? ¿Es difícil? ¿Terminará todo con Skynet y el auge de las máquinas?

La inteligencia artificial fuerte y débil

Primero, tenemos que diferenciar dos conceptos: IA fuerte y la débil. La IA fuerte es una máquina hipotética que es capaz de pensar y es consciente de su propia existencia, además, no solo puede resolver las tareas para las que está programada, sino que también puede aprender cosas nuevas.

La IA débil ya existe, se encuentra en todas las aplicaciones creadas para resolver problemas específicos, como reconocer imágenes o conducir un coche. La IA débil es la que habitualmente conocemos como “aprendizaje automático”.

Se desconoce todavía cuándo podrá inventarse la IA fuerte. Según los estudios de los expertos, tendremos que esperar otros 45 años, es decir, “algún día”. También afirman que la energía de fusión se comercializará dentro de 40 años, que es exactamente lo mismo que dijeron hace 50 años.

¿Qué podría ir mal?

Todavía no está claro cuándo se desarrollará la IA fuerte, pero la débil ya se encuentra en muchas áreas y cada año se extiende a diferentes sectores. El aprendizaje automático nos permite manejar tareas prácticas sin una programación obvia, ya que aprende de ejemplos.

Enseñamos a las máquinas a resolver problemas concretos, por lo que el modelo matemático resultante (lo que llamamos algoritmo de “aprendizaje”) no puede desarrollar repentinamente un deseo de esclavizar (o salvar) a la humanidad. Es decir, podemos estar tranquilos, la IA débil no generará en una situación similar a Skynet, pero otras cosas podrían salir mal.

1 . Malas intenciones

Si enseñamos a un ejército de drones a matar gente mediante inteligencia artificial, ¿serían éticos los resultados?

El año pasado surgió un pequeño escándalo en torno a este tema. Google estaba desarrollando software para un proyecto militar con drones llamado Project Maven que, en el futuro, podría ayudar a crear sistemas de armas completamente autónomos.

Como resultado, 12 empleados de Google dimitieron en acto de protesta y 4000 firmaron una petición pidiendo a la compañía que abandonara el contrato con las fuerzas armadas. Más de 1000 científicos reputados en el campo de la IA, la ética y la informática escribieron una carta abierta a Google, pidiendo a la empresa que abandonara el proyecto y respaldara un acuerdo internacional que prohibiera las armas autónomas.

2. La tendencia de los desarrolladores

Aunque los desarrolladores de algoritmos de aprendizaje automático no quieran dañar a nadie, lo que sí quieren muchos de ellos es ganar dinero, es decir, crean los algoritmos para beneficiarse ellos mismos y no necesariamente por el bien de la sociedad. Algunos algoritmos pueden recomendar los tratamientos más costosos como los que mejores resultados ofrecen al paciente, por ejemplo.

A veces, es la propia sociedad la que no tiene interés en que un algoritmo se convierta en un modelo para la sociedad. Por ejemplo, hay una fuerte relación entre la velocidad de tráfico y el índice de mortalidad debido a accidentes. Así que, podríamos programar los coches autónomos para que no circulen a más de 20 km/h, lo cual reduciría el número de muertes en las carreteras a casi cero, pero anularía la mayoría de los beneficios del coche.

3. Los parámetros del sistema no siempre tienen en cuenta la ética

Por defecto, los ordenadores no tienen principios éticos. Un algoritmo puede elaborar un presupuesto nacional con el objetivo de “aumentar el PIB/la productividad laboral/la esperanza de vida”, pero si no se incluyen limitaciones éticas en el programa del modelo, podría eliminar el presupuesto destinado a los colegios, los hospitales de cuidados paliativos y el medio ambiente, porque no aumentarían el PIB.

De hecho, si su propósito fuera más amplio, podría incluso decidir aumentar la productividad deshaciéndose de aquellos que no estén capacitados para trabajar.

La cuestión es: se deben incorporar principios éticos desde el comienzo.

4. Relatividad ética

La ética va cambiando con el tiempo y a veces lo hace muy rápido. Por ejemplo, las opiniones sobre ciertas cuestiones como los derechos LGTB y el matrimonio entre castas o interracial pueden cambiar significativamente de generación a generación.

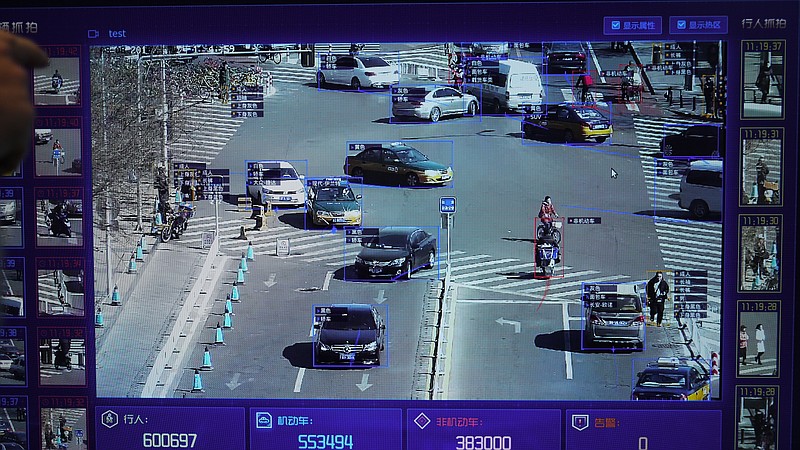

La ética también puede variar entre grupos del mismo país, por no hablar de distintos países. Por ejemplo, en China, se ha comenzado a utilizar el reconocimiento facial como principal medida de vigilancia masiva, sin embargo, otros países pueden ver este problema de manera diferente y la decisión puede depender según la situación.

El clima político también importa. Por ejemplo, la guerra contra el terrorismo ha cambiado significativamente (y muy rápido) algunas normas éticas e ideales en muchos países.

5. El aprendizaje automático cambia a los humanos

Los sistemas de aprendizaje automático (solo un ejemplo de IA que afecta a la gente directamente) te recomiendan nuevas películas según tu puntuación a otras y después de comparar tus preferencias con otros usuarios. A algunos sistemas ya se les da bastante bien.

Un sistema de recomendación de películas cambia tus preferencias con el tiempo y las limita. Sin él, te enfrentarías a la pesadilla de tener que ver películas malas y de géneros que no deseas. Pero con la IA, darás en el clavo con cada película y, al final, dejarás de investigar y solo consumirás lo que te ofrezca.

Cabe destacar que no solemos darnos cuenta de cómo nos manipulan estos algoritmos. Este ejemplo de las películas no asusta, pero piensa en las noticias o en la publicidad.

6. Falsas correlaciones

Una falsa correlación tiene lugar cuando cosas totalmente independientes empiezan a mostrar un comportamiento similar, lo que podría generar la ilusión de que puedan estar conectadas de alguna forma. Por ejemplo, ¿sabías que el consumo de margarina en EEUU está muy relacionado con la tasa de divorcio en Maine?

Está claro que una persona real, que depende de su experiencia personal y su inteligencia humana, asumiría de inmediato que cualquier conexión directa entre la margarina y el divorcio es muy poco probable. Sin embargo, un modelo matemático no posee ese conocimiento, solo aprende y generaliza datos.

Un ejemplo muy conocido es un programa que clasifica a los pacientes según el nivel de urgencia que concluyó que los pacientes asmáticos con neumonía no necesitaban tan urgentemente la asistencia como los pacientes con neumonía, pero sin asma. El programa comprobó los datos y concluyó que los pacientes con asma tienen menos peligro de muerte y, por tanto, no deberían ser una prioridad. Y lo cierto es que sus índices de mortalidad eran tan bajos porque siempre recibían atención urgente debido al riegos inherentes a su condición.

7. Circuitos de retroalimentación

Un circuito de retroalimentación es peor que las falsas correlaciones, ya que es una situación en la que las decisiones del algoritmo afectan a la realidad, que, a su vez, convence al algoritmo de que su conclusión es acertada.

Por ejemplo, un programa de prevención de la delincuencia en California sugirió que la policía debería enviar más oficiales a los barrios afroamericanos según el índice de delincuencia (el número de delito registrados). Pero al ver tantos coches de policía en el barrio, los residentes comenzaron a denunciar delitos con mayor frecuencia, lo que llevó a que los oficiales redactaran más protocolos e informes y resultó en un índice de criminalidad más alto, por lo que tendrían que destinar aún más patrullas a la zona.

8. Datos de referencia “contaminados” o “envenenados”

Los resultados del algoritmo de aprendizaje dependen de los datos de referencia que forman la base del aprendizaje. Los datos pueden ser erróneos y distorsionados por accidente o porque alguien los haya envenenado.

¿Cómo se pueden contaminar los datos de referencia? Por ejemplo, si los datos utilizados como muestra de formación para un algoritmo de contratación se han obtenido de una empresa con prácticas de contratación racistas, el algoritmo también será racista.

Microsoft una vez enseñó a un chatbot a comunicarse en Twitter permitiendo que cualquiera chateara con él. Tuvieron que desconectar el proyecto en menos de 24 horas porque los amables usuarios de Internet enseñaron rápidamente al bot a jurar y recitar Mein Kampf.

¿Y hay algún ejemplo de datos envenenados? Pues sí, un modelo matemático en un laboratorio de análisis de virus informáticos procesa un promedio de 1 millón de archivos por día, tanto limpios como dañinos. El panorama de amenazas cambia constantemente, por lo que los cambios del modelo se entregan a los productos instalados del cliente en forma de actualizaciones de la base de datos antivirus.

Un hacker puede seguir generando archivos maliciosos, muy similares a los limpios, y enviarlos al laboratorio. Esto puede llegar a difuminar la línea entre archivos limpios y dañinos, degradando el modelo y, quizás, desencadenando un falso positivo.

9. Engaño

Incluso un buen modelo matemático que haya demostrado su efectividad (que confíe en buenos datos) puede ser engañado, si se sabe cómo funciona. Por ejemplo, un grupo de investigadores descubrió cómo engañar al algoritmo de reconocimiento facial con unas gafas de colores especiales que introducirían distorsiones mínimas en la imagen y alterarían por completo el resultado.

Incluso en situaciones que no parecen involucrar nada complicado, una máquina puede ser engañada fácilmente utilizando métodos desconocidos para una persona inexperta en la materia.

Además, para derribar un modelo matemático de aprendizaje automático, los cambios no tienen que ser significativos; bastarán cambios mínimos, imperceptibles para el ojo humano.

Mientras la humanidad sea aún más inteligente que la mayoría de los algoritmos, los humanos podrán engañarlos. Imagina el aprendizaje automático de un futuro cercano que analiza el escáner de rayos x del equipaje en el aeropuerto en busca de armas. Un terrorista inteligente podrá poner un objeto junto a un arma de forma que esta sea invisible.

¿A quién culpar y qué hacer?

En el 2016, el Big Data Working Group de la administración de Obama publicó un informe que avisaba sobre “el potencial de codificar la discriminación en las decisiones automatizadas”. El informe también contenía un llamamiento para generar algoritmos que siguieran los principios de igualdad de oportunidades por defecto.

Es más fácil decirlo que hacerlo.

En primer lugar, los modelos matemáticos de aprendizaje automático son difíciles de probar y corregir. Evaluamos los programas paso a paso y sabemos cómo probarlos, pero con el aprendizaje automático, todo depende del tamaño de la muestra de aprendizaje, y no puede ser infinito.

Por ejemplo, aunque parezca increíble, la aplicación Google Photo solía reconocer y etiquetar a las personas de raza negra como gorilas. Como puedes imaginar, fue un escándalo y Google prometió arreglar el algoritmo. Sin embargo, después de tres años, Google acabó por prohibir las etiquetas a gorilas, chimpancés o monos para evitar el mismo error.

En segundo lugar, es complicado comprender y explicar las decisiones de los algoritmos. Una red neuronal organiza coeficientes para llegar a las respuestas correctas, pero ¿cómo? ¿Y qué se puede hacer para cambiar la respuesta?

Una investigación del 2015 mostró que las mujeres encuentran anuncios de trabajos bien remunerados en Google AdSense bien con mucha menos frecuencia que los hombres. A menudo, el servicio de entrega en el mismo día de Amazon no está disponible para los vecindarios afroamericanos. En ambos casos, los representantes de la compañía no pudieron explicar estas decisiones tomadas por los algoritmos.

Nadie tiene la culpa, así que tenemos que adoptar nuevas leyes y postular leyes éticas para la robótica. En mayo del 2018, Alemania dio el primer paso y publicó unas normas éticas para los automóviles de conducción autónoma que, entre otras cosas, cubre lo siguiente:

- La seguridad personal es la principal prioridad en comparación con el daño a animales o propiedades

- En caso de que un accidente sea inevitable, no debe haber discriminación; los factores distintivos son inadmisibles.

Pero lo realmente importante es que:

- Los sistemas de conducción automática se convertirán en un imperativo ético si causan menos accidentes que los conductores humanos.

Es evidente que cada vez confiaremos más en el aprendizaje automático, simplemente porque llevará a acabo muchas tareas mejor que nosotros. Por ello, es importante tener en cuenta estas taras, intentar anticiparse a todos los posibles problemas encontrados en la etapa de desarrollo y acordarse de supervisar el rendimiento de los algoritmos si algo va mal.

FUENTE: KASPERSKY BLOG (https://www.kaspersky.es/blog/machine-learning-nine-challenges/16771/)